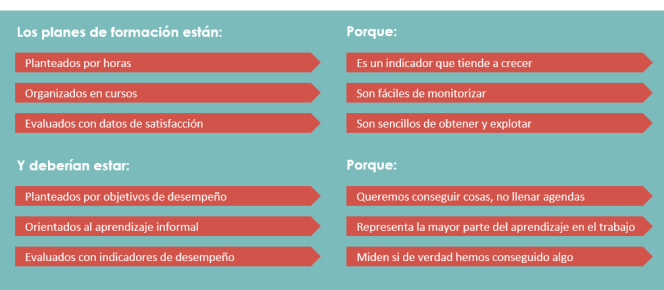

Este post empieza mal, porque realmente no habla de indicadores de aprendizaje, sino de indicadores de formación, y tampoco es que sean reflexiones que solo afectan a entornos virtuales. El aprendizaje tal y como lo entendemos en este contexto no es fácilmente medible, como mucho podemos tener sustitutos (proxies), medidas relacionadas que nos dan una idea sobre si efectivamente se produjo o no. Pero, igualmente, en formación corporativa el aprendizaje tampoco es nuestra meta: lo que buscamos es el desempeño, la mejora en la forma en que se llevan a cabo las tareas y que, a su vez, repercute en los objetivos que se alcanzan. Queremos que la gente sea buena en lo que hace y para eso, a veces, lo que hace falta es que aprendan. Y para que aprendan, a veces, hay que formarles.

Una evaluación no mide, por tanto, el aprendizaje, sino la capacidad de una persona para poner en práctica una habilidad en un contexto concreto. O, como escribe Will Thalheimer, «la capacidad para recordar información específica sobre antenas mientras están sentados con sus compañeros en el aula azul el 1 de abril de 3 a 4 de la tarde».

Dicho esto, esas medidas sustitutas pueden ser suficientemente buenas como para informar el diseño instruccional y conseguir mejoras. El uso de herramientas y materiales, la implicación en las tareas, los resultados obtenidos y el uso de recursos de apoyo son algunos grandes grupos de los que podemos intentar sacar conclusiones, siempre teniendo en cuenta que el indicador se basa en evidencia, es decir, tenemos que tener pruebas de que ocurrió lo que decimos. La implicación en las tareas o el seguimiento de una conferencia solo pueden medirse si tenemos un producto de ese proceso (como puede ser un entregable, una colección de mensajes, un historial de ediciones de un documento…).

Los indicadores, en cualquier caso, deben estar alineados con la aproximación pedagógica que se sigue, por dos motivos: comprobar que la estamos aplicando correctamente, y saber si funciona. Es decir, como mi concepción del proceso de aprendizaje va a determinar el tipo de recursos y herramientas que utilizo (si creo que la interacción con pares lo facilita procuraré que las tareas tengan una vertiente social), tendré que establecer indicadores que midan esa alineación (veré si interactuaron o no entre sí y trataré de comprobar cómo impactó eso en el resultado).

Con esta información recogida podemos tomar decisiones sobre el tipo de actividades didácticas que se requieren. Así, poco uso de los recursos de apoyo puede querer decir que no los necesitan (si el resto de indicadores son buenos) o que no son suficientes o no están bien planteados (si los resultados son pobres, es decir, si necesitan ayuda pero no la piden). Una recurrencia alta en el uso de las actividades puede sugerir que son demasiado complejas o que se usan como material de referencia, lo que puede ser bueno o malo dependiendo de si era lo que se pretendía.

Ya se ve que el indicador por sí mismo no dice gran cosa, porque siempre tiene que tener una medida de comparación. Una línea base o una distribución esperada de las mediciones pueden funcionar como criterios de contraste a la hora de sacar conclusiones. Las líneas base suelen ser más sencillas de conseguir, pero también resulta más complicado determinar si el impacto es adecuado o no; es decir, sí podemos saber si ha habido un impacto significativo, pero no (o más difícilmente) cuánto se parece al óptimo que queríamos conseguir. Contar con un modelo al que aspiramos que se parezcan nuestros resultados nos puede dar esa información verificando el ajuste entre él y nuestros resultados. El problema es que estos modelos son difíciles de determinar a menos que tengamos datos de experiencias anteriores. No hay mucha investigación sobre patrones de seguimiento de cursos, menos que proporcionen relaciones causales con el resultado, y menos aún que se refieran a cursos de corta duración. Sin embargo no es descabellado establecer una relación tentativa entre seguimiento y resultados dados ciertos parámetros (ajuste a conocimientos previos y validez interna de la evaluación, al menos) que nos puede ayudar a dibujar un patrón esperado y a tomar medidas cuando hay desviaciones individuales que no responden a otros factores identificables.

En cualquier caso, el indicador definitivo nos lo debe dar la transferencia del aprendizaje, y este es quizá el más complicado de obtener. Se trata esencialmente de comprobar si el presunto aprendizaje puede saltar del contexto en el que se produjo al contexto en el que la habilidad es necesaria. Hay habilidades que se prestan más a recoger mediciones cuantitativas, pero encuentro que métodos de evaluación cualitativa como el del caso de éxito de Brinkerhoff son de gran ayuda para estimar el impacto real de un programa formativo en más dimensiones que la de estricto incremento productivo a corto plazo.