A estas alturas está relativamente extendida la idea de que los planes de formación corporativa no pueden medirse en horas de gente sentada en un aula, sino que deben conseguir algún tipo de impacto en la organización. Es decir, el objetivo de la formación en el puesto de trabajo es conseguir un cambio en el desempeño de unas funciones, y un plan de formación es una hoja de ruta para conseguir un determinado impacto en una organización. Ese impacto se mide en términos de:

- Eficacia: la mejora reportada en el desempeño.

- Eficiencia: número de horas necesarias (cuanto más bajo, mejor) y calidad percibida (índice de satisfacción).

Las horas empleadas por los profesionales son recursos, igual que las empleadas por el equipo de formación, así que deben plantearse como un indicador a reducir, no a aumentar. Que un plan de formación aumente las horas impartidas puede justificarse porque más gente acceda a los cursos, o porque haya habido un cambio importante que requiera una capacitación masiva. De otra forma, el trabajo de diseño debe tender a optimizar las horas por alumno, es decir, a conseguir impactos significativos con una dedicación cada vez menor por parte de los profesionales. Obviamente esa función tiempo-resultados tiene una asíntota y normalmente habrá un número mínimo de horas necesarias, pero que no sea porque los diseñadores instruccionales nos acomodamos.

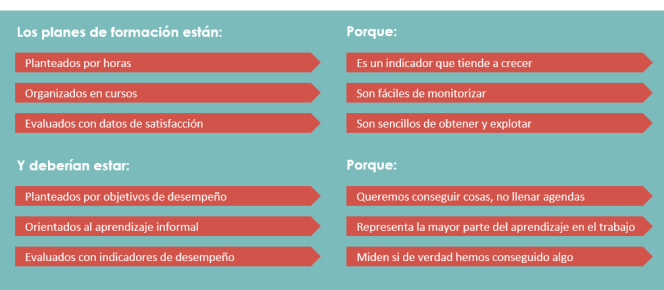

La planificación por horas es uno de los varios vicios del diseño de planes formativos, pero hay más:

La organización en cursos es lógica, estructurada y permite compartimentar contenidos, pero cuando trabajamos con competencias las interdependencias resultan complicadas de encasillar. Aún así, como la mayoría de la gente está acostumbrada a ese formato, posiblemente los problemas que causa se resuelven bien. La mayor dificultad es insertar el uso de una estructura por cursos en el día a día laboral, en el que las necesidades se cubren mejor con herramientas que faciliten el aprendizaje informal (comunicación con expertos, herramientas sociales o ayudas de trabajo).

Los objetivos de desempeño son importantes porque evitan caer en el volcado de información, que no es que sea simplemente una mala estrategia, es que puede ser contraproducente si no va, al menos, acompañada de práctica suficiente y bien diseñada. Que alguien tenga ciertas nociones sobre una tarea, no contrastadas mediante la práctica sistemática y monitorizada, puede darle una idea equivocada sobre su propia competencia, haciéndole creer que sabe más de lo que sabe y dando pie a errores y malas prácticas. La medida de una competencia es lo que haces, no lo que presuntamente sabes, así que ese riesgo queda anulado si medimos impacto y no aprendizaje.

Unas pocas acciones ayudan mucho a potenciar esos tres puntos:

- Dedicar recursos a rastrear problemas de desempeño. Buzones de sugerencias y cuestionarios periódicos, entrevistas con perfiles de coordinación… Lo que es un buen análisis de necesidades. Sobre este tema tienen buen material en la Diputación de Alicante, con la complejidad que tiene la formación en el sector público.

- Basar el aprendizaje en la práctica con expertos. Los talleres y estudios de caso (presenciales o remotos) tienen mejor tasa de transferencia al puesto de trabajo que las ponencias y presentaciones.

- Potenciar el uso de herramientas colaborativas. El aprendizaje informal surge en buena medida del contacto entre profesionales, y las oportunidades de mejora aparecen cuando puedes ver cómo hacen las cosas los demás. Por no hablar de las comunidades de práctica, que desde mi punto de vista son el mejor ejemplo de qué pasa cuando la estrategia de formación se enfoca a la solución de problemas y no al aprendizaje per se.

- Orientar los cursos a la evaluación de impacto: La formación, formal o informal, debe concluir solo cuando ya no hay fallos (no cuando un flujo sale bien una vez durante una evaluación). Para saber cuándo ocurre esto es imprescindible tener indicadores de resultados (no de aprendizaje) que permitan medir la estabilidad de los cambios, tanto percibidos como efectivos, con recogidas de información al mes, semestre y año de la primera capacitación, por ejemplo. Espacia la práctica para reducir el olvido y recuerda que lo que no se usa se pierde.

Sobre todo este tema no puedo dejar de recomendaros que sigáis a Jesús Martínez Marín, a quien tuve ocasión de conocer en 2012, durante un congreso en el que también estaba nada menos que Charles Jennings. Trabaja, por cierto, en el sector público, en el que la innovación en formación parece moverse con más soltura que en algunos departamentos empresariales de L&D.